AI HALLUCINATION LÀ GÌ? CÁC GIẢI PHÁP KIỂM SOÁT HIỆN TƯỢNG NÀY

Trong kỷ nguyên mà Trí tuệ Nhân tạo (AI) đang dần trở thành trái tim của mọi đổi mới công nghệ, chúng ta thường ngợi ca về khả năng phi thường của nó: từ việc phân tích dữ liệu khổng lồ, đưa ra dự đoán chính xác đến việc sáng tạo nội dung một cách đột phá. Tuy nhiên, đằng sau bức màn hào quang ấy, AI vẫn còn một "góc khuất" ít được nhắc đến nhưng lại vô cùng quan trọng, đó là hiện tượng AI Hallucination.

Tại TechData.AI, chúng tôi không chỉ khám phá những tiềm năng vô hạn của AI mà còn đối mặt trực diện với những thách thức vốn có của nó. Chúng tôi hiểu rằng, để xây dựng một tương lai nơi AI thực sự đáng tin cậy và mang lại giá trị bền vững, việc hiểu rõ và kiểm soát "ảo tưởng" của AI là điều tối quan trọng. Bài viết này sẽ mở cánh cửa để bạn cùng chúng tôi đi sâu vào định nghĩa, nguyên nhân, tác động và đặc biệt là những giải pháp tiên tiến để kiểm soát hiện tượng AI Hallucination, đảm bảo rằng công nghệ này sẽ luôn phục vụ con người một cách chân thực và hiệu quả nhất.

1. Giới thiệu về AI Hallucination – Khi Trí Tuệ Nhân Tạo "Ảo Tưởng"

Hãy tưởng tượng bạn đang trò chuyện với một người bạn rất thông minh, người có thể trả lời mọi câu hỏi của bạn với tốc độ đáng kinh ngạc. Nhưng đôi khi, người bạn này lại đưa ra những thông tin hoàn toàn sai lệch, không có căn cứ thực tế, nhưng lại nói ra với một sự tự tin tuyệt đối. Đó chính là một cách đơn giản nhất để hình dung về AI Hallucination.

AI Hallucination là gì?

Trong bối cảnh Trí tuệ Nhân tạo, đặc biệt là các mô hình ngôn ngữ lớn (LLMs – Large Language Models) như GPT, Bard, hoặc các mô hình tạo sinh hình ảnh, AI Hallucination (hay còn gọi là "ảo giác AI") là hiện tượng mô hình AI tạo ra thông tin không chính xác, phi logic, không liên quan hoặc hoàn toàn bịa đặt, nhưng lại trình bày nó như thể là sự thật khách quan. Điều đáng nói là, những thông tin "ảo tưởng" này thường rất trôi chảy, thuyết phục và khó bị phát hiện nếu người dùng không có kiến thức chuyên sâu về chủ đề đó.

Hiện tượng này không phải là do AI cố tình lừa dối chúng ta. Thực chất, nó là hệ quả của cách thức AI được huấn luyện và hoạt động. AI học từ dữ liệu mà nó được cung cấp, và nhiệm vụ của nó là dự đoán từ tiếp theo có khả năng nhất (trong trường hợp ngôn ngữ) hoặc pixel tiếp theo (trong trường hợp hình ảnh) dựa trên các mẫu hình đã học. Khi không có đủ thông tin, hoặc khi dữ liệu huấn luyện có lỗ hổng, hoặc khi các ràng buộc ngữ cảnh bị thiếu, AI có thể "tự bịa" ra thông tin để hoàn thành nhiệm vụ của mình một cách "trôi chảy" nhất, dẫn đến những "ảo giác" này.

Tại sao AI Hallucination lại quan trọng?

Trong một thế giới ngày càng phụ thuộc vào AI để ra quyết định, cung cấp thông tin và hỗ trợ công việc, việc AI "ảo tưởng" có thể dẫn đến những hậu quả nghiêm trọng. Imagine một hệ thống AI y tế đưa ra chẩn đoán sai, một công cụ pháp lý cung cấp tiền lệ án không tồn tại, hay một AI tài chính đưa ra lời khuyên đầu tư dựa trên dữ liệu hư cấu. Hậu quả sẽ không chỉ là sự phiền toái mà có thể là tổn thất về tài chính, thời gian, uy tín, thậm chí là tính mạng.

Hiểu rõ về AI Hallucination không chỉ giúp chúng ta sử dụng AI một cách thận trọng hơn mà còn mở ra con đường để phát triển các hệ thống AI mạnh mẽ hơn, đáng tin cậy hơn và an toàn hơn cho tương lai. Đây chính là kim chỉ nam cho mọi nỗ lực nghiên cứu và phát triển của TechData.AI.

2. Nguyên Nhân Sâu Xa Gây Ra Hallucination trong AI

Để kiểm soát một vấn đề, chúng ta cần hiểu rõ gốc rễ của nó. AI Hallucination không phải là một lỗi ngẫu nhiên, mà là hệ quả của nhiều yếu tố phức tạp liên quan đến dữ liệu, kiến trúc mô hình và quá trình suy luận của AI. Dưới đây là những nguyên nhân chính mà TechData.AI đã và đang nghiên cứu sâu rộng:

2.1. Chất lượng và đặc tính của dữ liệu huấn luyện

- Dữ liệu không đầy đủ hoặc thiên lệch (Bias): AI học từ dữ liệu. Nếu dữ liệu huấn luyện thiếu thông tin về một lĩnh vực cụ thể, hoặc chứa đựng sự thiên vị (ví dụ, chủ yếu là thông tin từ một nguồn duy nhất, không đa dạng), AI sẽ không có đủ cơ sở để tạo ra câu trả lời chính xác khi gặp những tình huống mới. Thay vì nói "tôi không biết", nó sẽ "đoán" hoặc "bịa" ra thông tin dựa trên những gì đã học được. Ví dụ: Một mô hình được huấn luyện chủ yếu trên văn bản tiếng Anh có thể tạo ra thông tin không chính xác hoặc vô nghĩa khi cố gắng tạo nội dung về các nền văn hóa phi phương Tây do thiếu dữ liệu đại diện.

- Dữ liệu lỗi thời hoặc không chính xác: Thế giới thay đổi liên tục. Nếu dữ liệu huấn luyện của AI đã cũ, nó sẽ không thể cập nhật những sự kiện, thông tin, hoặc xu hướng mới nhất. Ví dụ: Một LLM được huấn luyện đến năm 2023 có thể cung cấp thông tin không chính xác về các sự kiện thể thao lớn diễn ra vào năm 2024, bởi vì nó chưa bao giờ "thấy" dữ liệu đó.

- Tiếng ồn trong dữ liệu (Noise): Dữ liệu web thường chứa rất nhiều thông tin không đáng tin cậy, sai lệch, hoặc thậm chí là cố ý lừa dối. Khi AI học từ những "tiếng ồn" này, nó có thể tái tạo lại chúng dưới dạng "ảo giác".

2.2. Kiến trúc và hạn chế của mô hình AI

- Quá trình dự đoán dựa trên xác suất: Các mô hình ngôn ngữ lớn hoạt động bằng cách dự đoán từ hoặc token tiếp theo dựa trên xác suất cao nhất. Đôi khi, từ hoặc chuỗi từ có xác suất cao nhất lại không phải là thông tin chính xác nhất hoặc có ý nghĩa nhất trong ngữ cảnh thực tế. Mô hình không "hiểu" ngữ nghĩa sâu sắc mà chỉ "nhận diện" các mẫu hình.

- Tính năng ghi nhớ và khả năng suy luận bị giới hạn: AI hiện tại, đặc biệt là LLMs, có khả năng "ghi nhớ" một lượng lớn thông tin trong quá trình huấn luyện, nhưng lại không có khả năng suy luận logic hay hiểu biết thông thường (common sense) như con người. Khi gặp câu hỏi phức tạp hoặc yêu cầu một chuỗi suy luận, AI có thể ghép nối các mảnh thông tin một cách hợp lý về mặt cú pháp nhưng lại sai lệch về mặt ngữ nghĩa. Ví dụ: Yêu cầu AI tóm tắt một bài báo khoa học mà nó chưa từng đọc trước đây, nó có thể tạo ra một bản tóm tắt nghe có vẻ uyên bác nhưng lại chứa đựng những chi tiết không có thật trong bài báo.

- Overfitting (học tủ): Mô hình học quá sát với dữ liệu huấn luyện đến mức mất khả năng tổng quát hóa với dữ liệu mới. Khi gặp một truy vấn hơi khác so với những gì đã thấy, nó có thể "bịa" ra thông tin thay vì nhận ra sự thiếu hụt kiến thức.

2.3. Quy trình suy luận và thiếu kiểm chứng ngữ cảnh

- Thiếu cơ chế kiểm tra sự thật: Hầu hết các mô hình tạo sinh hiện tại không có cơ chế tích hợp để kiểm tra sự thật của thông tin mà chúng tạo ra dựa trên các nguồn đáng tin cậy bên ngoài. Chúng chỉ tạo ra đầu ra dựa trên các mẫu hình đã học được.

- Kích thước cửa sổ ngữ cảnh (Context Window) hạn chế: Các mô hình chỉ có thể xử lý một lượng thông tin nhất định tại một thời điểm (kích thước context window). Nếu một câu hỏi đòi hỏi thông tin vượt ra ngoài giới hạn đó hoặc cần kết nối nhiều thông tin từ các phần khác nhau của cuộc trò chuyện hoặc tài liệu, mô hình có thể gặp khó khăn và tạo ra thông tin không liên quan.

- "Áp lực" phải trả lời: Mô hình AI được thiết kế để luôn đưa ra câu trả lời. Chúng không có khả năng nói "tôi không biết" một cách tự nhiên. Áp lực này đôi khi buộc mô hình phải "tạo ra" một câu trả lời ngay cả khi nó không có đủ thông tin tin cậy, dẫn đến Hallucination.

Việc nhận diện và phân tích sâu các nguyên nhân này là bước đầu tiên và quan trọng nhất trong hành trình kiểm soát AI Hallucination. TechData.AI cam kết không ngừng nghiên cứu để giải quyết tận gốc những thách thức này, mang lại những giải pháp AI đáng tin cậy và bền vững.

3. Tác Động và Hậu Quả Của AI Hallucination Trong Thế Giới Thực

Sự "ảo tưởng" của AI không chỉ là một vấn đề lý thuyết hay một điểm yếu kỹ thuật; nó có những tác động cụ thể và đôi khi nghiêm trọng trong nhiều lĩnh vực của đời sống. Việc hiểu rõ những hậu quả này giúp chúng ta nhận thức được tầm quan trọng của việc kiểm soát AI Hallucination.

3.1. Thiệt hại về thông tin và lòng tin

- Lan truyền thông tin sai lệch (Misinformation & Disinformation): Đây là hậu quả rõ ràng nhất. AI có thể tạo ra tin tức giả, thông tin sai lệch về sức khỏe, lịch sử, hoặc chính trị, gây hoang mang trong cộng đồng. Ví dụ thực tế: Đã có trường hợp LLMs tạo ra các "dẫn chứng" từ các bài báo khoa học không tồn tại hoặc trích dẫn sai lệch luật pháp, khiến người dùng tin vào những thông tin đó và đưa ra quyết định dựa trên chúng.

- Giảm sút lòng tin vào công nghệ AI: Khi người dùng thường xuyên gặp phải thông tin sai lệch từ AI, niềm tin của họ vào công nghệ này sẽ bị xói mòn. Điều này có thể cản trở việc áp dụng AI rộng rãi, ngay cả khi nó có tiềm năng mang lại lợi ích to lớn.

3.2. Rủi ro trong các lĩnh vực nhạy cảm

- Y tế: Một hệ thống AI chẩn đoán bệnh có thể đưa ra triệu chứng không tồn tại hoặc gợi ý phương pháp điều trị không đúng, gây nguy hiểm trực tiếp đến sức khỏe và tính mạng bệnh nhân. Ví dụ: Một bác sĩ sử dụng AI để tham khảo thông tin về một loại thuốc hiếm, và AI "ảo tưởng" về liều lượng hoặc tác dụng phụ, dẫn đến sai lầm trong kê đơn.

- Pháp luật: AI hỗ trợ pháp lý có thể "bịa" ra các tiền lệ án, điều khoản luật không có thật, hoặc giải thích sai lệch các quy định pháp luật. Điều này có thể dẫn đến những quyết định sai lầm trong tòa án hoặc trong quá trình tư vấn pháp lý, gây ra thiệt hại tài chính và pháp lý nghiêm trọng. Ví dụ: Một luật sư sử dụng AI để tìm kiếm các vụ án tương tự và AI tạo ra một vụ án hoàn toàn giả mạo, dẫn đến việc xây dựng chiến lược bào chữa sai lầm.

- Tài chính: Trong lĩnh vực đầu tư và phân tích tài chính, thông tin sai lệch từ AI có thể dẫn đến các quyết định đầu tư tồi tệ, gây thua lỗ lớn cho cá nhân và tổ chức. Ví dụ: Một AI phân tích thị trường chứng khoán "tạo ra" thông tin về một công ty giả mạo, khuyến nghị mua cổ phiếu của công ty đó, gây thiệt hại nghiêm trọng cho nhà đầu tư.

3.3. Ảnh hưởng đến hiệu suất và chi phí vận hành

- Tăng chi phí kiểm soát và chỉnh sửa: Để đối phó với Hallucination, các tổ chức phải đầu tư thêm nguồn lực vào việc kiểm tra, xác minh và chỉnh sửa thông tin do AI tạo ra. Điều này làm tăng chi phí vận hành và giảm hiệu quả của việc tự động hóa.

- Giảm năng suất: Thay vì giúp tăng tốc công việc, Hallucination có thể khiến người dùng phải dành nhiều thời gian hơn để kiểm tra lại hoặc sửa chữa đầu ra của AI, làm giảm năng suất tổng thể.

3.4. Vấn đề đạo đức và trách nhiệm

- Ai chịu trách nhiệm? Khi AI tạo ra thông tin sai lệch gây hậu quả, câu hỏi về trách nhiệm pháp lý và đạo đức trở nên phức tạp. Liệu người phát triển AI, người triển khai AI hay người sử dụng AI phải chịu trách nhiệm?

- Lạm dụng: Hallucination có thể bị lạm dụng để tạo ra nội dung sai lệch, lừa đảo, hoặc thao túng dư luận, đặt ra những thách thức lớn về an ninh mạng và đạo đức xã hội.

Nhận thức sâu sắc về những tác động này thúc đẩy TechData.AI không ngừng nỗ lực tìm kiếm và áp dụng các giải pháp tiên tiến nhất. Chúng tôi tin rằng chỉ khi giải quyết được vấn đề Hallucination, AI mới có thể thực sự phát huy hết tiềm năng của mình một cách an toàn và có trách nhiệm.

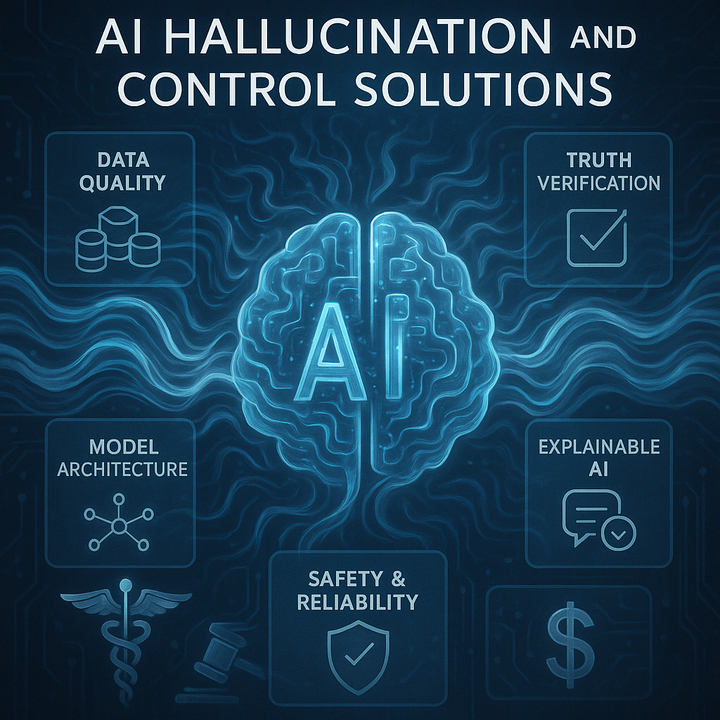

4. Các Giải Pháp Kiểm Soát và Giảm Thiểu AI Hallucination Hiệu Quả

Đối mặt với thách thức từ AI Hallucination, cộng đồng nghiên cứu và các doanh nghiệp công nghệ hàng đầu như TechData.AI đã và đang phát triển nhiều giải pháp sáng tạo, từ việc cải thiện dữ liệu, tinh chỉnh mô hình đến quy trình vận hành. Dưới đây là những cách tiếp cận hiệu quả nhất để kiểm soát và giảm thiểu hiện tượng này:

4.1. Cải thiện Chất lượng và Quản lý Dữ liệu Huấn luyện (Data-Centric Approaches)

Dữ liệu là nền tảng của mọi mô hình AI. Một nền tảng vững chắc sẽ giảm thiểu nguy cơ "ảo giác".

- Làm sạch và Chọn lọc Dữ liệu (Data Cleaning & Curation):

- Mô tả: Loại bỏ dữ liệu nhiễu, không chính xác, lỗi thời, hoặc trùng lặp khỏi tập dữ liệu huấn luyện. Xây dựng các tập dữ liệu được kiểm định kỹ lưỡng, có nguồn gốc rõ ràng và đáng tin cậy.

- Ví dụ thực tế: Thay vì huấn luyện LLM trên toàn bộ Internet, chúng ta có thể chọn lọc chỉ sử dụng các nguồn thông tin được kiểm duyệt (như Wikipedia, các trang báo uy tín, tạp chí khoa học đã được bình duyệt). TechData.AI áp dụng các thuật toán tự động và kiểm tra thủ công để đảm bảo nguồn dữ liệu đầu vào là "sạch" và chất lượng cao nhất cho các dự án phát triển AI của khách hàng.

- Tăng cường Dữ liệu (Data Augmentation) và Đa dạng hóa:

- Mô tả: Bổ sung dữ liệu đa dạng để lấp đầy khoảng trống kiến thức của mô hình, đặc biệt là trong các lĩnh vực ít phổ biến hoặc dễ gây thiên vị.

- Ví dụ thực tế: Nếu AI thường xuyên "ảo tưởng" về các sự kiện lịch sử ở một khu vực địa lý cụ thể, chúng ta cần chủ động thu thập và bổ sung thêm dữ liệu lịch sử từ các nguồn đáng tin cậy về khu vực đó. Đối với các mô hình sản xuất nội dung, việc đưa vào nhiều phong cách viết, giọng điệu, và chủ đề khác nhau giúp mô hình linh hoạt và chính xác hơn.

- Kiểm chứng Sự thật Dựa trên Dữ liệu (Fact-checking Datasets):

- Mô tả: Sử dụng các bộ dữ liệu được thiết kế đặc biệt để kiểm tra sự thật, trong đó mỗi câu hoặc mệnh đề được gắn nhãn là đúng hay sai. Điều này giúp mô hình học cách phân biệt thông tin chính xác.

- Ví dụ thực tế: Các tập dữ liệu như FEVER (Fact Extraction and VERification) được sử dụng để huấn luyện mô hình khả năng xác minh thông tin bằng cách đối chiếu với các bằng chứng thực tế, giúp giảm Hallucination trong các hệ thống hỏi đáp.

4.2. Nâng cao Kiến trúc và Quá trình Huấn luyện Mô hình (Model-Centric Approaches)

Cải tiến bản thân mô hình AI là chìa khóa để xử lý các vấn đề nội tại.

- Sử dụng Kỹ thuật Tạo Sinh Tăng Cường Truy Xuất (Retrieval-Augmented Generation - RAG):

- Mô tả: Thay vì chỉ dựa vào kiến thức nội tại của mô hình, RAG cho phép AI truy xuất thông tin từ một kho dữ liệu bên ngoài, đáng tin cậy (ví dụ: cơ sở dữ liệu nội bộ của doanh nghiệp, tài liệu chuyên ngành được kiểm duyệt) và sử dụng thông tin đó để tạo ra câu trả lời. Điều này giảm thiểu đáng kể khả năng "bịa đặt" thông tin.

- Ví dụ thực tế: Một hệ thống chatbot hỗ trợ khách hàng của TechData.AI được triển khai cho ngân hàng có thể sử dụng RAG để truy vấn chính sách vay, lãi suất, hoặc quy định cụ thể của ngân hàng từ một cơ sở dữ liệu nội bộ được cập nhật liên tục, thay vì cố gắng "nhớ" hay "đoán" chúng. Khi khách hàng hỏi về một điều khoản vay cụ thể, AI sẽ tìm kiếm thông tin chính xác trong các tài liệu gốc và trình bày lại, thay vì đưa ra một câu trả lời mơ hồ hoặc sai lệch.

- Điều chỉnh Tinh chỉnh (Fine-tuning) và Huấn luyện Tăng cường từ Phản hồi của Con người (Reinforcement Learning from Human Feedback - RLHF):

- Mô tả: Sau khi huấn luyện sơ bộ, mô hình được tinh chỉnh thêm trên một tập dữ liệu nhỏ hơn, chất lượng cao, chuyên biệt cho từng tác vụ hoặc ngành nghề. RLHF sử dụng phản hồi của con người để "dạy" AI phân biệt câu trả lời tốt (chính xác, hữu ích, không Hallucination) và câu trả lời kém chất lượng.

- Ví dụ thực tế: Một LLM ban đầu có thể tạo ra thông tin y tế không chính xác. Bằng cách tinh chỉnh nó với một tập dữ liệu nhỏ gồm các bài báo y khoa đã được xác minh và sử dụng các chuyên gia y tế để đánh giá và xếp hạng chất lượng đầu ra của AI, chúng ta có thể cải thiện đáng kể độ tin cậy của nó trong lĩnh vực y tế.

- Định lượng Độ không chắc chắn (Uncertainty Quantification):

- Mô tả: Phát triển các cơ chế để AI không chỉ đưa ra câu trả lời mà còn thể hiện mức độ tự tin của nó về câu trả lời đó. Khi AI không chắc chắn, nó có thể báo hiệu cho người dùng hoặc yêu cầu thêm thông tin.

- Ví dụ thực tế: Thay vì trả lời chắc nịch "Hành tinh X có 5 mặt trăng", AI có thể nói "Theo dữ liệu tôi được huấn luyện, hành tinh X có khả năng có 5 mặt trăng, nhưng thông tin này có thể chưa được xác nhận hoàn toàn." Điều này giúp người dùng cẩn trọng hơn khi sử dụng thông tin.

4.3. Tối ưu hóa Kỹ thuật Nhắc nhở (Prompt Engineering) và Quy trình Kiểm soát

Cách chúng ta tương tác với AI cũng đóng vai trò quan trọng trong việc giảm thiểu Hallucination.

- Thiết kế Prompt rõ ràng và cụ thể:

- Mô tả: Cung cấp cho AI hướng dẫn rõ ràng, ngữ cảnh đầy đủ, và giới hạn phạm vi thông tin mong muốn. Tránh các câu hỏi quá mơ hồ hoặc quá rộng.

- Ví dụ thực tế: Thay vì hỏi "Hãy nói cho tôi biết về AI", hãy hỏi "Hãy tóm tắt lịch sử phát triển của AI từ những năm 1950 đến nay, tập trung vào các cột mốc quan trọng và đưa ra nguồn tham khảo cụ thể nếu có." Việc yêu cầu nguồn tham khảo trực tiếp khuyến khích AI tìm kiếm thông tin thay vì bịa đặt.

- Chuỗi tư duy (Chain-of-Thought) và Giải thích từng bước:

- Mô tả: Yêu cầu AI trình bày quá trình suy luận từng bước một trước khi đưa ra câu trả lời cuối cùng. Điều này giúp chúng ta dễ dàng phát hiện lỗi hoặc sự phi logic trong quá trình suy nghĩ của AI.

- Ví dụ thực tế: Khi giải một bài toán, yêu cầu AI không chỉ đưa ra đáp số mà còn trình bày từng bước giải. Nếu có bước nào đó không hợp lý, chúng ta có thể chỉnh sửa prompt hoặc yêu cầu AI xem xét lại.

- Vòng lặp Phản hồi của Con người (Human-in-the-Loop - HITL):

- Mô tả: Đặt con người vào quy trình kiểm soát đầu ra của AI. Các chuyên gia sẽ xem xét, chỉnh sửa và xác nhận thông tin do AI tạo ra trước khi nó được công bố hoặc sử dụng.

- Ví dụ thực tế: Trong một dự án tạo nội dung tự động, các biên tập viên con người sẽ đọc lại và chỉnh sửa các bài viết do AI tạo ra để loại bỏ Hallucination và đảm bảo chất lượng. TechData.AI thường xuyên tích hợp HITL vào các giải pháp của mình để đảm bảo độ chính xác và tin cậy cao nhất.

4.4. Áp dụng Trí tuệ Nhân tạo Giải thích được (Explainable AI - XAI)

- Mô tả: XAI là một lĩnh vực nghiên cứu nhằm giúp các hệ thống AI trở nên minh bạch và dễ hiểu hơn, cho phép con người hiểu được lý do tại sao AI đưa ra một quyết định hoặc tạo ra một thông tin cụ thể.

- Ví dụ thực tế: Khi một mô hình AI y tế đưa ra chẩn đoán, XAI có thể chỉ ra những triệu chứng, xét nghiệm, hoặc hình ảnh cụ thể nào đã dẫn đến kết luận đó, giúp bác sĩ xác minh và đưa ra quyết định cuối cùng một cách tự tin hơn. Việc biết được nguồn gốc của thông tin do AI tạo ra giúp phát hiện ra liệu đó có phải là Hallucination hay không.

Bằng cách kết hợp các giải pháp này, TechData.AI không chỉ giảm thiểu nguy cơ AI Hallucination mà còn xây dựng nên những hệ thống AI mạnh mẽ, minh bạch và thực sự đáng tin cậy, giúp doanh nghiệp và cá nhân khai thác tối đa tiềm năng của công nghệ một cách an toàn và hiệu quả.

5. Tương Lai Của AI An Toàn và Đáng Tin Cậy – Vai Trò Của TechData.AI

Chúng ta đang sống trong một kỷ nguyên biến đổi sâu sắc nhờ sự trỗi dậy của Trí tuệ Nhân tạo. AI Hallucination, dù là một thách thức lớn, nhưng cũng đồng thời là một lời nhắc nhở quan trọng rằng AI không phải là phép màu mà là một công cụ cần được xây dựng, tinh chỉnh và quản lý một cách cẩn trọng. Việc kiểm soát "ảo giác" của AI không chỉ là một yêu cầu kỹ thuật mà còn là một trách nhiệm đạo đức, quyết định đến mức độ tin cậy và sự chấp nhận của AI trong tương lai.

Tại TechData.AI, chúng tôi không chỉ là những người tiên phong trong việc khai thác sức mạnh của AI mà còn là những kiến trúc sư tận tâm xây dựng một tương lai nơi AI có thể hoạt động một cách an toàn, chính xác và đáng tin cậy. Chúng tôi hiểu rằng, chỉ khi AI đưa ra thông tin dựa trên sự thật và logic, nó mới thực sự trở thành đối tác đắc lực, giải phóng con người khỏi những công việc lặp lại và mở ra những chân trời sáng tạo mới.

Tầm nhìn của TechData.AI về AI không Hallucination

Chúng tôi hướng tới việc phát triển và triển khai các giải pháp AI có khả năng tự kiểm chứng, minh bạch trong quy trình suy luận và liên tục học hỏi từ phản hồi của con người. Điều này bao gồm:

- Nghiên cứu và phát triển liên tục: Khám phá những kiến trúc mô hình mới, các phương pháp huấn luyện tiên tiến và cơ chế kiểm soát chất lượng dữ liệu hiệu quả nhất để chủ động ngăn chặn Hallucination từ gốc.

- Áp dụng RAG và RLHF tiên tiến: Tích hợp sâu rộng các kỹ thuật tạo sinh tăng cường truy xuất và huấn luyện tăng cường từ phản hồi của con người vào mọi giải pháp AI của chúng tôi, đảm bảo thông tin do AI cung cấp luôn được dựa trên bằng chứng và được con người kiểm định.

- Xây dựng cộng đồng và chia sẻ tri thức: TechData.AI tin rằng việc giải quyết vấn đề Hallucination cần sự hợp tác của cả cộng đồng. Chúng tôi tích cực chia sẻ kiến thức, kinh nghiệm và các giải pháp đã được kiểm chứng để thúc đẩy sự phát triển của AI an toàn trên toàn cầu.

- Giải pháp tùy chỉnh cho doanh nghiệp: Mỗi doanh nghiệp có bộ dữ liệu và nhu cầu riêng. TechData.AI cung cấp các giải pháp AI tùy chỉnh, được thiết kế để hoạt động tối ưu trong môi trường dữ liệu đặc thù của bạn, giảm thiểu Hallucination và tối đa hóa hiệu quả kinh doanh.

AI Hallucination không phải là một rào cản không thể vượt qua, mà là một thách thức thúc đẩy sự đổi mới. Bằng sự chuyên môn sâu rộng, tầm nhìn sáng tạo và cam kết mang lại giá trị thực tiễn, TechData.AI tự tin đồng hành cùng bạn trên con đường chinh phục và ứng dụng AI một cách thành công và bền vững.

Hãy cùng TechData.AI kiến tạo tương lai đáng tin cậy

Nếu bạn là doanh nghiệp đang tìm kiếm giải pháp AI đáng tin cậy, tối ưu hóa quy trình và giảm thiểu rủi ro từ Hallucination, hãy liên hệ với TechData.AI ngay hôm nay. Đội ngũ chuyên gia của chúng tôi sẵn sàng lắng nghe, phân tích và cung cấp lộ trình phát triển AI phù hợp nhất với mục tiêu của bạn.

Chúng tôi cũng khuyến khích bạn tiếp tục khám phá thư viện kiến thức phong phú của chúng tôi để tìm hiểu sâu hơn về thế giới AI đầy hấp dẫn. Kiến thức là sức mạnh, và TechData.AI luôn ở đây để trang bị cho bạn sức mạnh đó.

Đừng ngần ngại chia sẻ bài viết này với đồng nghiệp, bạn bè và những ai quan tâm đến tương lai của AI. Cùng nhau, chúng ta có thể xây dựng một hệ sinh thái AI minh bạch, hiệu quả và đáng tin cậy cho tất cả mọi người.

Liên hệ với TechData.AI để nhận tư vấn chuyên sâu về các giải pháp AI đột phá và đáng tin cậy!