Với những câu hỏi và câu trả lời phỏng vấn Data Engineering hàng đầu này, bạn có thể chắc chắn rằng mình sẽ vượt qua cuộc phỏng vấn tiếp theo.

Câu hỏi phỏng vấn kỹ sư dữ liệu thường gặp

Ở vòng phỏng vấn kỹ sư dữ liệu chung, bạn sẽ được giám đốc nhân sự đặt câu hỏi về kinh nghiệm làm việc và giá trị bạn mang lại cho công ty.

Điều gì làm cho bạn trở thành ứng cử viên tốt nhất cho vị trí này?

Nếu người quản lý tuyển dụng chọn bạn để phỏng vấn qua điện thoại, họ hẳn đã thấy điều họ thích trong hồ sơ của bạn. Vì vậy, bạn có thể tự tin về câu hỏi này và nói về kinh nghiệm và sự phát triển nghề nghiệp của bạn.

Xem xét hồ sơ của công ty và mô tả công việc trước khi ngồi phỏng vấn là rất quan trọng. Làm như vậy sẽ giúp bạn điền vào chỗ trống những gì người quản lý tuyển dụng đang tìm kiếm. Nếu họ đang tìm kiếm một cá nhân có thể thiết kế và quản lý các đường dẫn dữ liệu, hãy đảm bảo rằng bạn nói cụ thể về điều đó.

Nói chung, bạn có thể nghĩ về các kỹ năng, kinh nghiệm và kiến thức của mình cũng như cách những yếu tố này khiến bạn nổi bật giữa đám đông.

Theo bạn, trách nhiệm hàng ngày của một kỹ sư dữ liệu là gì?

Không có câu trả lời tuyệt đối ở đây, nhưng bạn có thể chia sẻ kinh nghiệm về công việc cuối cùng và trách nhiệm của bạn với tư cách là một kỹ sư. Mô tả công việc cũng là một nơi tốt để tìm kiếm thông tin này.

Tuy nhiên, nhìn chung, trách nhiệm hàng ngày của kỹ sư dữ liệu bao gồm:

- Phát triển, thử nghiệm và duy trì cơ sở dữ liệu

- Phát triển các giải pháp dữ liệu dựa trên yêu cầu kinh doanh

- Thu thập dữ liệu

- Phát triển, xác thực và duy trì các đường ống dữ liệu cho ETL cũng như mô hình hóa, chuyển đổi và phục vụ dữ liệu.

- Trong một số trường hợp, triển khai các mô hình thống kê.

- Duy trì chất lượng dữ liệu bằng cách làm sạch, xác thực và giám sát luồng dữ liệu.

- Cải thiện độ tin cậy, hiệu suất và chất lượng của hệ thống.

- Tuân thủ các nguyên tắc bảo mật và quản trị dữ liệu để thực hiện từng tác vụ.

Điều khó khăn nhất mà bạn thấy khi trở thành một kỹ sư dữ liệu là gì?

Mặc dù điều này sẽ phụ thuộc vào từng cá nhân, nhưng có một số chủ đề chung trong các cuộc phỏng vấn kỹ sư dữ liệu. Giống như các nhà khoa học dữ liệu và kỹ sư DevOps, phần khó khăn nhất khi trở thành Data Engineer có thể là học và thành thạo các công nghệ khác nhau. Bạn cần tiếp tục tích hợp các công cụ mới có thể cải thiện hiệu suất, bảo mật, độ tin cậy và ROI của hệ thống dữ liệu.

Việc đảm bảo rằng bạn biết về quản lý thảm họa, quản trị dữ liệu, giao thức bảo mật, yêu cầu kinh doanh và dự đoán nhu cầu dữ liệu cũng có thể khó nắm bắt. Đó là một công việc khó khăn khi bạn phải chịu trách nhiệm cho rất nhiều thứ

Bạn có kinh nghiệm với những công cụ hoặc khuôn khổ dữ liệu nào?

Một lần nữa, câu trả lời phỏng vấn kỹ sư dữ liệu này sẽ dựa trên kinh nghiệm của bạn. Nếu bạn đồng điệu với các công cụ hiện đại và tích hợp của bên thứ ba, bạn sẽ không gặp vấn đề gì khi trả lời câu hỏi này.

Bạn có thể nói về các công cụ để quản lý cơ sở dữ liệu, kho dữ liệu, sắp xếp dữ liệu, đường dẫn dữ liệu, quản lý đám mây, làm sạch dữ liệu, lập mô hình và chuyển đổi cũng như xử lý hàng loạt và thời gian thực.

Hãy nhớ rằng, không có câu trả lời sai cho câu hỏi này. Người phỏng vấn đang đánh giá kỹ năng và kinh nghiệm của bạn.

Những câu hỏi này dành cho những cá nhân có kinh nghiệm. Nếu bạn là người mới bắt đầu và muốn bắt đầu sự nghiệp trong lĩnh vực kỹ thuật dữ liệu, hãy hoàn thành lộ trình nghề nghiệp Kỹ sư dữ liệu với Python. Nó bao gồm 19 khóa học sẽ dạy cho bạn khái niệm kỹ thuật dữ liệu hiện đại, ngôn ngữ lập trình, công cụ và khung.

Câu hỏi phỏng vấn quy trình Data engineer

Sau các vòng phỏng vấn chung, thông thường bạn sẽ chuyển sang giai đoạn kỹ thuật bao gồm các thử thách viết mã, giải quyết vấn đề, thiết kế hệ thống cơ sở dữ liệu trên bảng trắng, bài kiểm tra mang về nhà và các câu hỏi phân tích.

Giai đoạn này có thể khá căng thẳng, vì vậy, biết một số câu hỏi và câu trả lời phỏng vấn kỹ thuật dữ liệu thông thường có thể giúp bạn vượt qua cuộc phỏng vấn

Theo tôi qua một dự án mà đã thực hiện từ đầu đến cuối.

Câu trả lời này sẽ đến một cách tự nhiên nếu trước đây bạn đã từng làm việc trong một dự án kỹ thuật dữ liệu khi còn là sinh viên hoặc chuyên gia. Điều đó đang được nói, chuẩn bị trước thời hạn luôn luôn hữu ích. Hãy chắc chắn rằng bạn giải thích nó bắt đầu như thế nào và bạn đang giải quyết vấn đề kinh doanh nào. Hơn nữa, giải thích từng bước từ việc truy cập dữ liệu thô và chuyển đổi nó thành dữ liệu cấu trúc được làm sạch.

Đôi khi bạn đang làm việc trên nhiều dự án và bạn đơ người trước câu hỏi này. Để tránh điều này xảy ra, bạn nên xem lại năm dự án gần đây nhất mà bạn đã thực hiện. Bạn có thể đọc tài liệu dự án và hiểu tuyên bố vấn đề. Kiểm tra ví dụ dưới đây:

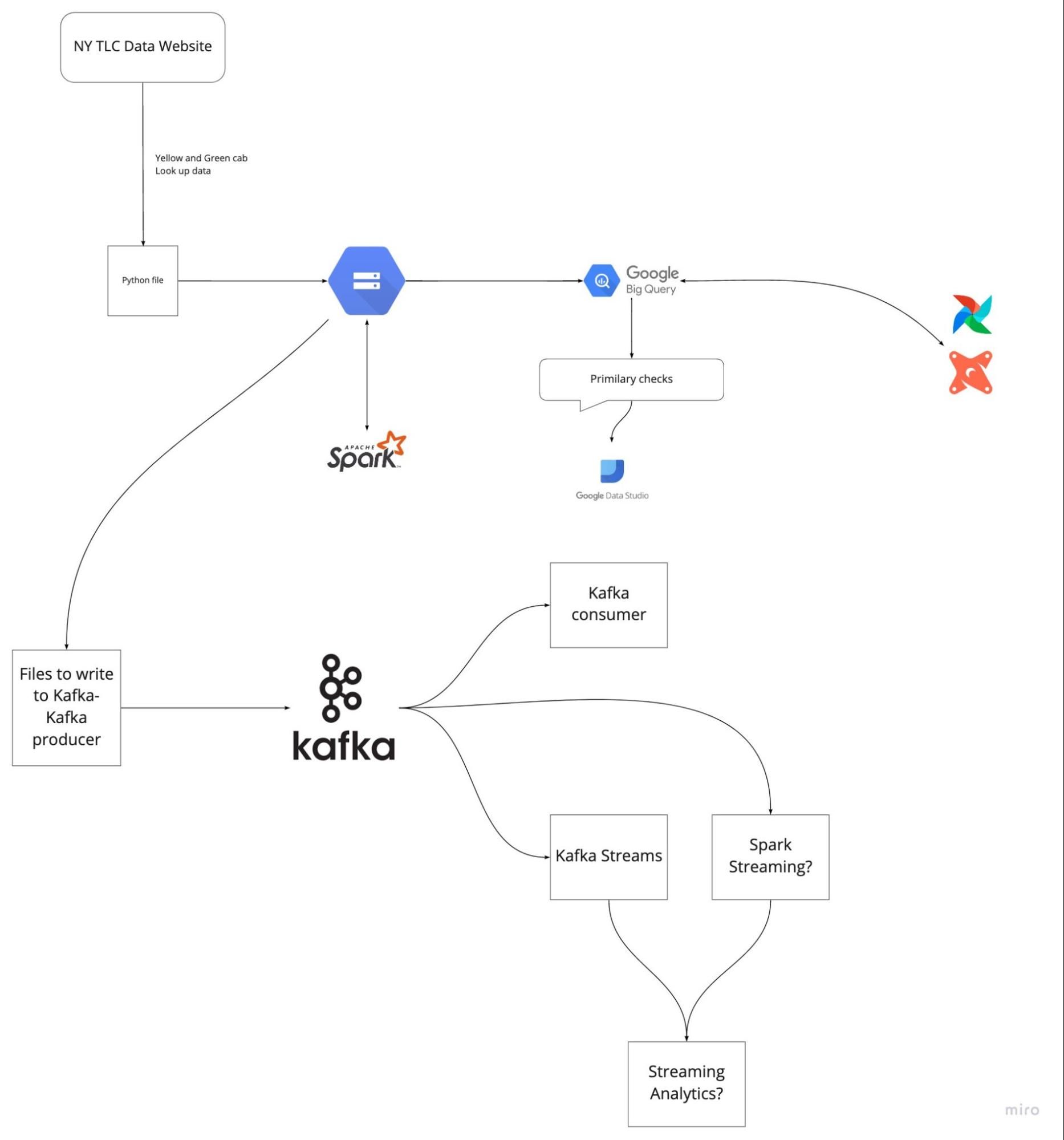

Trong dự án trên, chúng tôi đang nhập dữ liệu Bản ghi chuyến đi TLC, xử lý, chuyển đổi và phục vụ dữ liệu đó bằng các luồng Kafka và Spark.

Trong dự án:

- GCP, Terraform và Docker được sử dụng cho môi trường đám mây

- GCP, Airflow và Postgres được sử dụng để nhập dữ liệu

- BigQuery và Airflow cho kho dữ liệu data warehouse

- BigQuery, PostgreSQL, Google Studio và Metabase cho kỹ thuật phân tích

- Spark để xử lý hàng loạt

- Spark và Kafka để truyền dữ liệu

Câu hỏi phỏng vấn Junior data engineer

Bạn đã làm việc với những công cụ ETL nào? yêu thích của bạn là gì, và tại sao?

Ở đây, bạn nên đề cập đến danh sách các công cụ mà bạn đã thành thạo và giải thích lý do tại sao bạn đã chọn một số công cụ nhất định cho các dự án nhất định.

Người quản lý tuyển dụng đang đánh giá kinh nghiệm và kiến thức của bạn về các công cụ ETL khác nhau, vì vậy hãy giải thích lý do bạn chọn các công cụ về mặt ưu và nhược điểm.

Bạn cũng có thể kể đến các công cụ nguồn mở phổ biến như dbt, Spark, Kafka và Airbyte. Bạn có thể làm mới kiến thức của mình về ETL bằng cách tham gia khóa học Giới thiệu về Kỹ thuật dữ liệu.

Câu hỏi phỏng vấn về kĩ thuật của data engineer

Các công cụ phổ biến của Data Engineering

Image by Author

Điều phối dữ liệu là gì và bạn có thể sử dụng công cụ nào để thực hiện điều đó?

Phối hợp dữ liệu là một quy trình tự động để truy cập dữ liệu thô từ nhiều nguồn, thực hiện các kỹ thuật làm sạch, chuyển đổi và lập mô hình dữ liệu cũng như phục vụ dữ liệu đó cho các tác vụ phân tích. Các công cụ phổ biến nhất là Apache Airflow, Prefect, Dagster và AWS Glue.

Bạn sử dụng công cụ nào cho analytics engineering?

Kỹ thuật phân tích là một quy trình trong đó chúng tôi truy cập dữ liệu đã xử lý, biến đổi dữ liệu đó, áp dụng mô hình thống kê và trực quan hóa dữ liệu đó dưới dạng báo cáo và bảng điều khiển. Các công cụ phổ biến là dbt (công cụ xây dựng dữ liệu), BigQuery, Postgres, Metabase, Google Data Studio và Tableau.

Cách chuẩn bị cho cuộc phỏng vấn Kỹ sư dữ liệu

Trước khi xuất hiện trong một cuộc phỏng vấn, bạn nên xem lại tất cả các khái niệm và thuật ngữ tiêu chuẩn được sử dụng trong kỹ thuật dữ liệu. Hơn nữa, bạn nên chuẩn bị cho một cuộc phỏng vấn kỹ thuật.

Nắm vững SQL: Bạn nên thực hành tạo, sửa đổi và quản lý cơ sở dữ liệu. Hơn nữa, bạn nên thành thạo phân tích dữ liệu, mô hình hóa và chuyển đổi.

Giải quyết các thách thức về mã hóa: Giải quyết các thách thức về mã hóa Python, Scala hoặc C++. Hầu hết các công ty đánh giá kỹ năng lập trình bằng cách đưa ra các bài kiểm tra mang về nhà và các thử thách viết mã trực tiếp.

Thiết kế đường ống ETL: thực hành để tạo đường ống dữ liệu, ETL hoặc phân phối. Bạn cần hiểu cách kiểm tra, xác thực, mở rộng quy mô và duy trì các đường ống dẫn dữ liệu.

Kỹ thuật phân tích: thực hành tải, chuyển đổi và phân tích dữ liệu. Tìm hiểu cách tạo trang tổng quan về chất lượng dữ liệu và hiệu suất hệ thống.

Xem lại các câu hỏi tiềm năng: chuẩn bị cho cuộc phỏng vấn bằng cách xem lại các câu hỏi mẫu. Nhận quyền truy cập vào hàng trăm câu hỏi bằng cách tìm kiếm đơn giản trên Google.

Tìm hiểu về các công cụ kỹ thuật dữ liệu hiện đại: ngay cả khi bạn không có kinh nghiệm với các công cụ kỹ thuật dữ liệu hiện đại, bạn nên biết cách chúng hoạt động và cách chúng tích hợp với các công cụ khác. Các công ty luôn tìm kiếm các công cụ tốt hơn có thể cải thiện hiệu suất với chi phí thấp hơn.

Tìm hiểu về xử lý hàng loạt và truyền trực tuyến: Apache Spark được sử dụng để xử lý hàng loạt và Apache Kafka được sử dụng để truyền dữ liệu. Những công cụ này đang có nhu cầu cao và chúng sẽ giúp bạn có được một công việc ở những công ty hàng đầu.

Môi trường: Trong một số trường hợp, người phỏng vấn sẽ hỏi về điện toán đám mây (GCP, AWS, Azure), Docker, scripting, Terraform và Kubernetes. Bạn có thể sử dụng các công cụ này để thiết lập tài nguyên lưu trữ và máy tính tại chỗ hoặc đám mây. Hiểu những công nghệ này và tích hợp chúng vào các dự án danh mục đầu tư là một cách thực hành tốt.

Tham khảo lộ trình khoá Data Engineer tại TechData.AI

Chi tiết: TechData.AI - Data Engineer Course